Исследователи Intel придумали улучшенный метод генерации кадров для игр

Компания Intel, которая включилась в гонку графических ускорителей только недавно, уже успела сделать весьма интересное открытие. Исследователи компании сумели создать алгоритм генерации кадров, который не добавляет в игру никаких инпут-лагов (задержки ввода).

Все подробности о работе нового алгоритма доступны на GitHub одного из исследователей Intel. Если коротко, то G-buffer Free Frame Extrapolation (GFFE) рабоает совсем не так, как уже существующие DLSS, FSR или XeSS-FG. Эти решения используют одинаковый подход: последовательно визуализируют и сохраняют два кадра в видеопамяти, не отображая их. Затем они или с помощью шейдеров (AMD), или с помощью нейросетей (Nvidia и Intel) анализируют эти кадры, чтобы создать «искусственный» кадр на основе этой информации. Этот кадр «вставляют» между двумя отрендеренными кадрами, и уже только затем выводят на монитор.

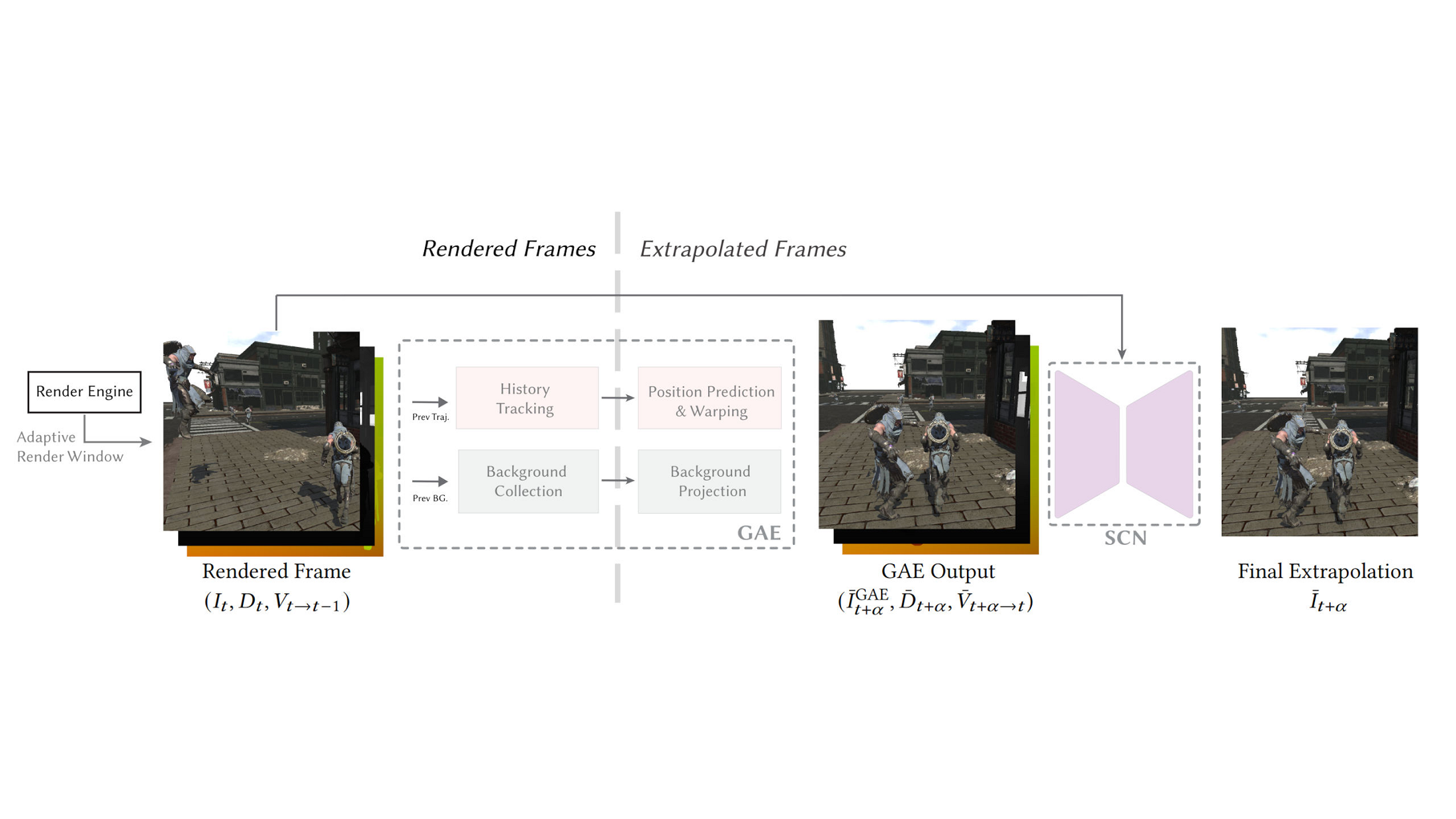

Естественно, все три технологии не дают идеальной генерации кадров. В частности, из-за инпут-лага. GFFE же работает иначе — на основе экстраполяции кадров. Новая система не «перехватывает» два кадра и не «впихивает» между ними сгенерированный. Она сохраняет историю отрендеренных ранее кадров, и с их помощью «рисует» дополнительный кадр. Этот самый кадр затем вставляется уже после нормальных кадров, благодаря чему получается прирост производительности.

GFFE также отличается неплохой скоростью работы (6,6 миллисекунд для генерации одного 1080p-кадра), и требует доступ только к кадрам. В общем и целом, эта технология — «естественная эволюция» существующих технологий генерации кадров. Появится ли она в новых видеокартах (Intel уже анонсировала новую линейку, AMD и Nvidia только готовятся) — неясно, но было бы неплохо.